Aprende a gestionar +100 Pipelines en AWS con CDK

Aprende a gestionar +100 Pipelines en AWS con CDK Descubre cómo transformar la gestión de infraestructura escalando a más de

Aprende a optimizar costes en Amazon EKS combinando KEDA y Karpenter. Miguel Fontanilla (Sender) explica cómo lograr un 40% de ahorro.

Durante la reciente edición del SpainClouds Summit, uno de los temas más destacados fue la optimización de costes y eficiencia en arquitecturas orientadas a eventos dentro de Amazon EKS. La sesión estuvo a cargo de Miguel Fontanilla, Arquitecto Profesional de Amazon, AWS Community Builder y actual líder del equipo de plataforma en la nube de Sender.

Fontanilla desgranó cómo su equipo logró reducir costes en un 40% y mejorar drásticamente la respuesta ante picos de tráfico implementando una estrategia combinada de KEDA y Karpenter. A continuación, te contamos los puntos clave de su intervención técnica.

Para entender la solución, primero debemos entender el problema. Sender opera como un «Uber para camiones», un marketplace logístico digital cuyo tráfico varía enormemente: muy alto durante horas de oficina y muy bajo por las noches y fines de semana.

Su arquitectura se basa en Amazon EKS (Kubernetes), Lambda y un bus de eventos principal con Kafka. Inicialmente, utilizaban las herramientas estándar de escalado:

HPA (Horizontal Pod Autoscaler) para los workloads.

Cluster Autoscaler para los nodos.

Sin embargo, este enfoque presentaba limitaciones críticas:

Para resolver la parte de los contenedores, Fontanilla explicó la implementación de KEDA (Kubernetes Event-Driven Autoscaler). Esta herramienta no sustituye al HPA, sino que lo «vitaminiza», añadiendo un ciclo de control que alimenta al HPA con métricas externas.

Beneficios clave de KEDA explicados por el experto:

Es posible configurar un ScaledObject que escale tanto por el lag de Kafka como por el uso de CPU, logrando una inteligencia de escalado mucho más granular.

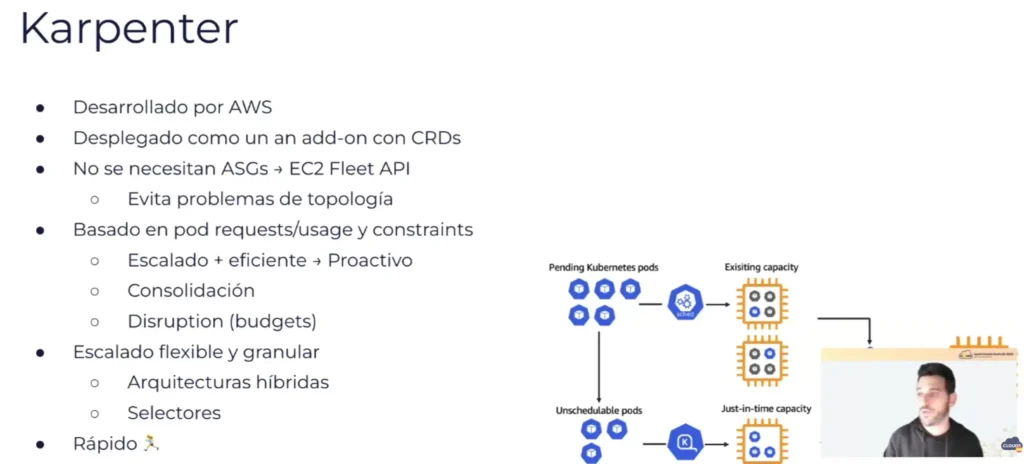

La segunda pieza del puzle es Karpenter, un proyecto open source iniciado por AWS que revoluciona el aprovisionamiento de nodos al eliminar la necesidad de grupos de autoescalado (Auto Scaling Groups).

¿Por qué Karpenter supera al Cluster Autoscaler? Según explicó el líder de plataforma de Sender, Karpenter observa los pending pods y llama directamente a la API de EC2 Fleet para aprovisionar exactamente la capacidad necesaria.

Es posible configurar un ScaledObject que escale tanto por el lag de Kafka como por el uso de CPU, logrando una inteligencia de escalado mucho más granular.

La implementación de esta arquitectura híbrida (KEDA + Karpenter) en Sender arrojó resultados tangibles que Fontanilla compartió con métricas reales:

Reducción de Costes: Lograron reducir la factura de computación en un 40%.

Uso de Spot: Incrementaron el uso de instancias Spot casi 8 veces, aprovechando los descuentos de AWS sin sacrificar disponibilidad gracias a la rapidez de Karpenter.

Velocidad de Reacción: El sistema responde a eventos en menos de 10 segundos (a veces menos de 5), garantizando un escalado rápido ante picos de demanda.

Eficiencia en Desarrollo: Los entornos no productivos escalan a cero absoluto durante los fines de semana, reduciendo el coste a mínimos.

Para cerrar, el ponente enfatizó un requisito técnico indispensable: definir correctamente los «Resource Requests». Dado que Karpenter toma decisiones de aprovisionamiento basándose en lo que los pods «piden», si los desarrolladores solicitan más CPU/RAM de la necesaria, Karpenter sobre-aprovisionará nodos, encareciendo la factura.

SmartClouds helps businesses get in front of the right technical audience. We are experts in content creation and community management. We’ll help you showcase your products and the problems you solve.

Aprende a gestionar +100 Pipelines en AWS con CDK Descubre cómo transformar la gestión de infraestructura escalando a más de

Cómo Azure Databases y la IA revolucionan las aplicaciones modernas (RAG y Copilot) Así es la integración de IA en

Cómo crear Agentes de IA con Microsoft Copilot y Azure Aprende a construir flujos de trabajo complejos con Copilot Studio

El futuro sin contraseñas: WebAuthn, FIDO2 y el reto de la Criptografía Cuántica Descubre cómo WebAuthn y FIDO2 eliminan las

Cómo integrar Arquitectura de Soluciones y FinOps para controlar los costes en la nube Descubre cómo integrar Arquitectura de Soluciones

Estrategia FinOps as Code para automatizar el ahorro ¿Miedo a abrir tu factura de AWS o Azure a fin de